¿Cuál será el impacto de la inteligencia artificial en las artes, en concreto en la producción musical? Éste es el eje central del Sónar+D de este año. El encuentro de innovación y cultura digital que acompaña al festival de música, que este año cumple 30 años, se pregunta sobre cuáles serán las implicaciones culturales, éticas, económicas e industriales de las nuevas herramientas y procesos creativos vinculados a la IA.

En esta edición, que abre sus puertas este jueves día 15 y hasta el 17 de junio se puede ver, escuchar, tocar y debatir sobre cómo se aplica la IA a la producción musical o audiovisual, al tiempo que se abordarán las posibles amenazas del uso cada vez más extendido de la IA y se estudiará cómo proteger la propiedad intelectual en esta nueva realidad.

El grupo de investigación EKHO de la Universidad de Barcelona, liderado por la doctora Magda Polo, ha organizado en el contexto del Sónar+D el International Symposium on Soundscape, Advanced Music and AI (ISSAM) para hablar sobre los retos de la IA en el arte y la música "como una herramienta más, no como una amenaza", explica.

Antònia Folguera, una de las comisarias del Sónar+D, apunta que la IA puede tener retos tecnológicos y creativos en lo que se refiere a la creación de música. La portavoz explica que para que un robot o una IA toque bien el piano o componga una canción sólo es necesario diseñar un sistema para que lo haga. "Este es un problema técnico, pero a los músicos la música hecha por máquinas no les sorprende", afirma. Así, cuando superamos esta actual fase de "demo de la IA que estamos viviendo, seguramente entonces sí que podremos resolver retos creativos", apunta la experta.

Sergi Jordà, investigador del Grupo de Tecnología Musical (GTM) de la Universitat Pompeu Fabra, es de la misma opinión cuando afirma que ahora mismo "la música que hace la IA no es avanzada, es música retrasada". Sin embargo, es imparable.

Los problemas de la música creada por IA: dilución del valor de la música, problemas de copyright, penuria económica para los músicos, homogeneidad cultural y occidentalización de la música

Hace un año el GTM realizó una encuesta entre más de 80 expertos internacionales en producción y educación musical relacionados con la IA. "En ese momento muy pocos expertos apuntaban que la generación de música comercial sería relevante. Actualmente, pocos artistas afirman utilizar IA para producir música. Lo que sí sabemos es que hace poco un grupo de expertos pidió una moratoria sobre la IA", dice Jordán.

La misma encuesta apunta a que los problemas derivados de la música creada por IA pueden ser: "Dilución del valor de la música, problemas de copyright, penuria económica para los músicos, homogeneidad cultural y occidentalización de la música, una pérdida de diversidad".

En manos de unos pocos

Si bien la investigación en IA está mucho más avanzada en texto e imagen que en música, debido a sus dificultades técnicas, las big tech han invertido millones y recursos. Estas empresas se han gastado millones en entrenar el espacio latente de sus IA, alimentando los cerebros de estas máquinas con todos los datos recogidos a través de un (o varios) sistema sensorizador. Hecho esto, la IA puede imitar nuestros procesos de conocimiento, como cálculos, reflexiones, síntesis, etc.

Cuando un músico hace música y produce una cosa única siempre es a partir de una serie de información que hemos recogido a lo largo de la vida, cómo los dataset de las IA

Microsoft tiene ya programas que sólo con un input musical generan acompañamientos, versiones e incluso sonidos en directo; Open AI también tiene su versión y Google ha lanzado MusicLM, que permite generar música a partir de texto. "La IA está en manos de tres o cuatro, Microsoft ha invertido 10.000 millones de dólares para impulsar ChatGPT -que consume cada día 700.000 dólares de electricidad-, y Google ha utilizado todo YouTube para entrenar su IA, nadie tiene acceso a esa cantidad de datos para entrenar una IA", dice el profesor.

Crear a partir del conocimiento propio (o compartido)

La IA crea, como hemos dicho, a partir de conocimiento, información y datos preexistentes que digiere para producir texto, imágenes o música. Diríamos que todo lo que produce es derivado de algo preexistente.

Ahora bien, cuando un músico hace música y produce algo único siempre es a partir de una serie de información que hemos recogido a lo largo de la vida, como los dataset de las IA. Y parece que a los músicos no les piden royalties por incorporar información a su imaginario con la que compondrá música, pero con las máquinas esto levanta otros temas. ¿De quiénes son los derechos de la información que ha utilizado una IA para crear? ¿A quién debemos pagar los royalties?

Así, las IA destapan cuestiones éticas y morales severas. "Con las versiones de sampling -trabajos con versiones reconocibles-, en la industria musical durante los 80 no se ha resuelto demasiado bien. Ahora, la IA puede generar canciones con la voz de artistas conocidos, un rasgo identitario de cada humano. La IA nos permite cantar con la voz de cualquier persona", dice Folguerola. Y en este sentido, Polo subraya que "se puede llegar a suplantar la identidad, lo que comporta un gran conflicto ético".

¿Cobrar para ser copiado?

Según explica la portavoz de Sónar+D, ya hay quien permite a artistas y autores retirar de los datasets de las IA sus creaciones. De hecho, el 12 de abril las Mayores pidieron a las big tech que no querían que entrenaran sus IA con sus músicas.

Y esto ocurre mientras se espera que se desarrolle algún tipo de plataforma blockchain para poder enviar al artista original la parte de dinero que toque de una obra creada por IA. Mientras esto no ocurre, crece la precarización de los creadores. "Solo un 0,4% de los artistas que están en Spotify viven de los royalties del streaming", apunta Jordà.

La cantidad de música que existe hace difícil que los artistas vivan exclusivamente de su música. Internet está inundado y la cosa irá a más. En 2019 Spotify recibía cada día 40.000 canciones, en 2021 ya eran 60.000 cada día y la cifra sigue subiendo. La IA amenaza con inundar las plataformas con música generada automáticamente, pero es que esto ya está ocurriendo en China y muchas de las canciones de jazz o chill de Spotify también son generadas por IA. Ah, y Apple ya ha comprado una startup de generación musical por IA.

Jordano (GTM): "Solo un 0,4% de los artistas que son a Spotify viven de los royalties del streaming"

En enero del 2023 los artistas visuales empezaron a quejarse de que las IA les copiaban las imágenes, en música esto todavía no ha ocurrido. "Todo debería formar parte del dominio público, pero vivimos en un sistema capitalista en el que se invierte mucho tiempo y recursos para hacer música, y por tanto es justo que todo el mundo sea retribuido justamente si se utiliza para una obra derivada", aclara Folguerola.

Otra derivada de la creación de música con IA es que la mayor parte de información empleada para entrenar a las IA provendrá de occidente, lo que conllevará, probablemente, una fuerte homogeneización cultural.

La (larga) historia de los retos técnicos

Las máquinas han realizado música desde hace décadas y la tecnología se ha utilizado para crear música desde hace muchos años. "Ada Lovelace ya previó que las computadoras podrían componer música", recuerda Jordà. En 1957, Lejarem Hiller programó unas computadoras que crearon la primera partitura hecha con ordenador, Illiac suite, que fue muy criticada en la época, se decía que no tenía "alma". Que es exactamente lo que ocurre ahora con la música creada con IA.

"Pero una vez la gente ha integrado la tecnología y se la ha hecho suya, se ha utilizado para crear música. La historia de la música está llena de ejemplos de adaptar cosas que no estaban pensadas para hacer música para, precisamente, hacer música", sigue Folguerola. Ahora mismo, la pregunta que se le hace a la IA es si las máquinas pueden tocar como los humanos. "La respuesta es sí, pero no sabemos si van a crear la música del futuro o música diferente a la actual", dice la portavoz del Sónar+D.

El futuro de la música

Los instrumentos electrónicos aparecieron para imitar los acústicos en forma, sonido y uso similar, pero resultó que tenían distorsión. Cuando los artistas aceptaron que eran instrumentos y sueños diferentes, los incorporaron a la hora de crear e incluso acabaron creando lenguajes nuevos, cómo el rock, el pop o más tarde la música electrónica.

Jordano (GTM): "Nadie sabe qué pasará, pero la industria musical solo tiene 180 años, por lo tanto, lo que pase no será la hecatombe. La música tiene 40.000 años y no se acabará"

La tecnología supuso cambios culturales profundos en todas partes. Más adelante, los ordenadores optimizaron más los procesos de crear música y también abrieron la puerta a crear música que no se podía hacer con sintetizadores. "La tecnología no hará más que avanzar y la acabaremos incorporando como una herramienta más", prevé la doctora Polo y vaticina que "¿acaso se creará un género de música nuevo?".

Jordà dice que la industria no sabe qué pasará, "pero quizás entramos en la era de los aficionados, música personalizada, música biométrica o terapéutica, música instantánea, interactiva, ¡las posibilidades están ahí!". El experto dice que "nadie sabe qué va a pasar, pero la industria musical sólo tiene 180 años, por tanto, lo que pase no será la hecatombe. La música tiene 40.000 años y no se acabará".

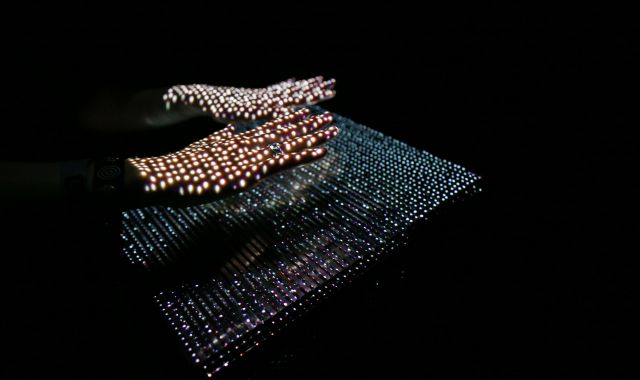

"Ahora con la IA podremos hacer otras cosas y seguramente cambiará incluso la forma de los instrumentos. Seguramente en algún momento podremos crear música solo con el cuerpo, bailando, guiñando un guiño. Cada estilo de música tiene su estilo de baile, y la música hecha con IA seguramente tendrá uno nuevo. ¿Cómo bailaremos con la música que nos proporcionará la IA? No lo sé, pero tengo ganas de verlo", concluye Folguerola.

The right way

El grupo de investigación Ekho de la Universitat de Barcelona, liderado por la doctora Magda Polo, ha partido del mundo del cantante catalano-senegalés Leïti Sène para componer la pieza The right way que se presenta en el festival Sónar+D.

Los investigadores han estudiado el entorno y los elementos y circunstancias que han alimentado al rapero catalán a lo largo de su vida para crear, con ayuda de inteligencia artificial, una canción sobre el artista, es decir, sobre su ADN como persona y cantante.

A partir de un estudio de su entorno y su hábitat han creado un tema que relata su personalidad y cómo crea Los investigadores han captado la esencia del artista a través de entrevistas y han podido entrenar una IA a partir de los temas que tiene en la red y mucha más información obtenida a partir de entrevistas personales. Además, clonaron su voz para generar el nuevo tema.

El tema, que empezó a pensarse en mayo del 2022 ya desarrollarse en octubre pasado, se dará a conocer el jueves día 15 durante el Sónar+D.